近期,DeepSeek這款應用因其出色的功能而備受用戶追捧,然而,由于服務器承載壓力巨大,時常出現無響應的情況。為了獲得更流暢的體驗,越來越多的用戶開始傾向于本地部署,而這種部署方式的具體效果則取決于個人的硬件配置。

AMD在x86處理器領域一直走在前列,并率先將AI能力引入其中。銳龍7040系列處理器就集成了獨立的NPU AI引擎,而后續的銳龍8040系列、銳龍AI 300系列以及銳龍AI MAX 300系列,在AI性能上更是不斷攀升。

AMD銳龍AI處理器所搭載的NPU,目前處于行業領先地位,其算力高達每秒50萬億次,即50 TOPS,這樣的性能使得它成為體驗DeepSeek的理想選擇。

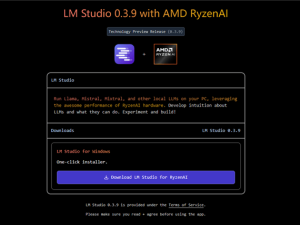

對于那些已經擁有銳龍AI筆記本的用戶來說,通過LM Studio平臺,他們可以輕松地在本地部署并體驗DeepSeek R1精簡版推理模型。以下是具體的操作步驟:

首先,需要安裝AMD Adrenalin 25.1.1或更新版本的顯卡驅動。然后,訪問lmstudio.ai/ryzenai,下載LM Studio 0.3.8或更新版本,并進行安裝。在安裝完成后,可以直接跳過引導屏幕,進入軟件主界面。

接下來,點擊“發現”標簽頁,選擇適合自己的DeepSeek R1 Distill版本。具體選擇依據個人需求而定。在軟件頁面右側,勾選“Q4 K M”量化模式,并點擊“下載”按鈕。下載完成后,返回聊天選項頁,從下拉菜單中選擇已下載的DeepSeek R1 distill版本,并確保勾選“手動選擇參數”選項。

在“GPU卸載”設置中,將滑塊移至最大值,以優化性能。最后,點擊“模型加載”按鈕,即可在本地體驗DeepSeek R1推理模型。

不同規模的參數模型,其性能和體積也各不相同,因此,用戶需要根據自己的硬件設備選擇最適合的參數量。例如,頂級配置的銳龍AI MAX+ 395處理器,搭配64GB或128GB內存,最高可以支持DeepSeek-R1-Distill-Llama-70B模型。若內存為64GB,則需將可變顯存設置為高。而搭配32GB內存,并將可變顯存自定義為24GB,則可支持DeepSeek-R1-Distill-Qwen-32B模型。

對于銳龍AI HX 370和AI 365處理器,搭配24GB或32GB內存,可以支持DeepSeek-R1-Distill-Qwen-14B模型。而銳龍7040/8040系列,則需搭配32GB內存,才能支持到同一模型。AMD還建議將所有Distill運行在Q4 K M量化模式下,以獲得最佳性能。

對于臺式機用戶,AMD RX 7000系列顯卡也已支持本地部署DeepSeek R1。其中,RX 7900 XTX旗艦顯卡最高可支持DeepSeek-R1-Distill-Qwen-32B模型,而RX 7900 XT、7900 GRE、7800 XT、7700 XT以及7600 XT均可支持到DeepSeek-R1-Distill-Qwen-14B模型。對于RX 7600以及新發布的RX 7650 GRE顯卡,則更適合運行DeepSeek-R1-Distill-Llama-8B模型。