IBM近日宣布了一項(xiàng)革命性的光學(xué)技術(shù)突破,這項(xiàng)技術(shù)有望徹底改變AI模型的訓(xùn)練方式,不僅速度提升至光速級(jí)別,還能顯著減少能源消耗。據(jù)該公司透露,若將此項(xiàng)技術(shù)應(yīng)用于數(shù)據(jù)中心,其節(jié)省的能源量足以滿足5000個(gè)美國家庭一年的用電需求。

傳統(tǒng)數(shù)據(jù)中心內(nèi)部主要依賴銅線連接各類設(shè)備,其中包括GPU加速器。然而,這些GPU在等待數(shù)據(jù)輸入時(shí)常常處于空閑狀態(tài),不僅浪費(fèi)了大量時(shí)間,還消耗了可觀的能源,增加了運(yùn)營成本。IBM指出,盡管數(shù)據(jù)中心通過光纖電纜與外部高效連接,但內(nèi)部通信方式卻未能跟上這一速度。

IBM高級(jí)副總裁兼研究總監(jiān)Dario Gil表示,隨著生成式AI對(duì)能源和處理能力的需求日益增加,數(shù)據(jù)中心必須迎來一場(chǎng)變革。他強(qiáng)調(diào),共封裝光學(xué)技術(shù)(CPO)正是推動(dòng)這一變革的關(guān)鍵。通過CPO技術(shù),未來的芯片將能夠像光纖電纜一樣高效地傳輸數(shù)據(jù),從而實(shí)現(xiàn)更快、更可持續(xù)的通信,為處理復(fù)雜的AI工作負(fù)載奠定基礎(chǔ)。

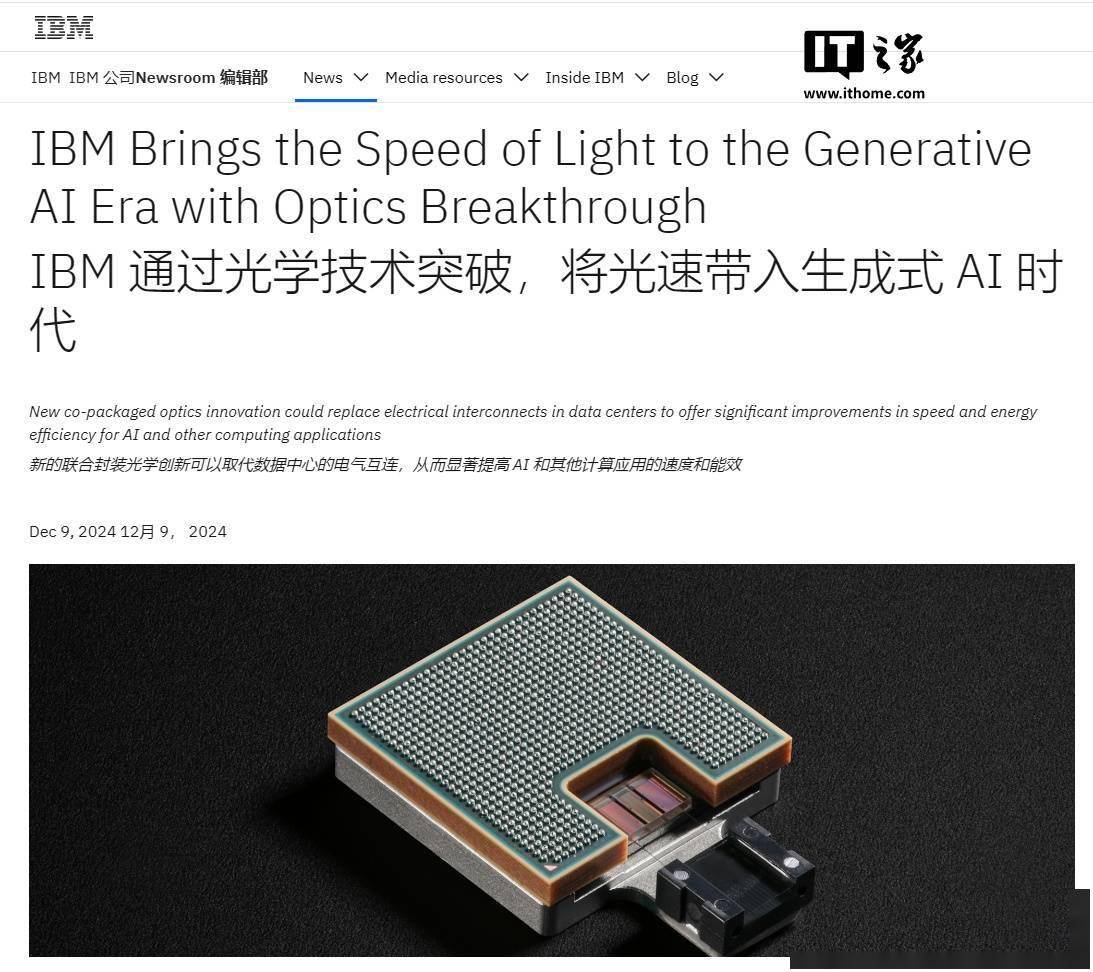

IBM在一篇技術(shù)論文中詳細(xì)介紹了其CPO原型的創(chuàng)新之處。這項(xiàng)技術(shù)通過大幅提升數(shù)據(jù)中心的帶寬,有效減少了GPU的閑置時(shí)間,從而加速了AI處理過程。據(jù)IBM介紹,采用CPO技術(shù)后,大型語言模型(LLM)的訓(xùn)練時(shí)間將從原本的三個(gè)月大幅縮短至三周。更高的能源效率還意味著更低的能源消耗和訓(xùn)練成本。