DeepSeek V3大模型在全球范圍內引發轟動,AMD Instinct數據中心GPU迅速跟進,實現了對該版本的全面支持,并集成了SGLang推理框架優化,確保為用戶提供卓越的性能表現。

DeepSeek-V3是一款開源的混合專家MoE模型,其擁有驚人的6710億個參數,成為開源社區中的明星模型。憑借創新的模型架構,DeepSeek-V3打破了高效低成本訓練的記錄,贏得了行業內的高度贊譽。這款多模態模型不僅繼承了DeepSeek V2的多頭潛在注意力機制MLA和MoE架構,還開創性地引入了無輔助損失的負載平衡策略,并設定了多token預測訓練目標,進一步提升了性能。

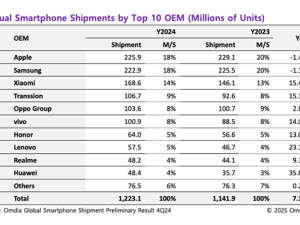

在主流基準測試中,DeepSeek-V3的表現令人矚目,與GPT-4o、laude 3.5 Sonnet、Qwen2.5-72B等頂級開源和閉源模型相比毫不遜色。特別是在長文本處理、數學及代碼編程能力方面,DeepSeek-V3展現出超群實力。

AMD ROCm開源軟件與AMD Instinct數據中心GPU加速器的強強聯合,為DeepSeek-V3的開發提供了堅實的基礎設施支持。在開發的關鍵階段,這一組合發揮了至關重要的作用,再次彰顯了AMD對開源AI軟件的堅定承諾。同時,它也助力開發者打造出強大的視覺推理和理解應用。

DeepSeek-V3采用了FP8低精度訓練,而AMD ROCm平臺對FP8的支持極大優化了計算過程,特別是推理性能的提升尤為顯著。通過支持FP8,AMD ROCm有效解決了內存瓶頸和高延遲等問題,使得在硬件限制內運行更大模型或批次成為可能。與FP16相比,FP8精度計算顯著減少了數據傳輸和計算的延遲,實現了更高效的訓練和推理。

為了推動DeepSeek相關應用的開發,AMD將繼續加強ROCm開源開發生態的建設,確保開發者能夠基于AMD Instinct數據中心GPU,及時開展DeepSeek相關的開發工作,實現最佳性能和擴展性。

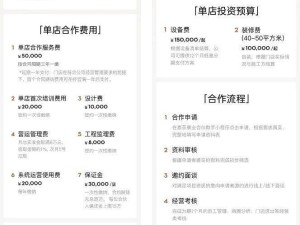

對于希望使用DeepSeek-V3的開發者來說,AMD還提供了詳盡的使用教程。開發者可以通過訪問特定網址,獲取SGLang對DeepSeek-V3模型推理的完整支持。教程中詳細指導了如何創建ROCm Docker鏡像、啟動Docker容器、登錄Hugging Face、啟動SGLang服務器以及生成文本等步驟。教程還包含了性能基準測試的指導,幫助開發者評估和優化模型性能。

對于需要將FP8權重轉換為BF16權重的用戶,AMD也提供了轉換腳本。用戶只需按照教程中的指示操作,即可輕松完成轉換過程。